Într-un experiment recent, cercetătorii au folosit modele mari de limbaj pentru a traduce activitatea creierului în cuvinte.

Video

Gândește-te la cuvintele care ți se învârteau în cap: acea glumă fără gust pe care ai păstrat-o cu înțelepciune pentru tine la cină; impresia ta fără voce despre noul partener al celui mai bun prieten al tău. Acum imaginați-vă că cineva ar putea asculta.

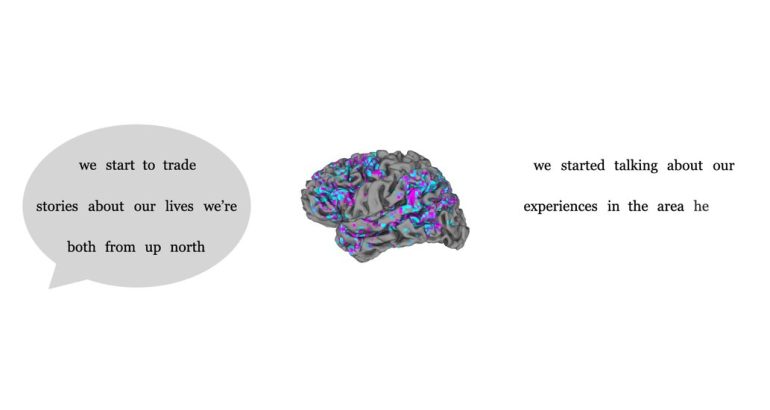

Luni, oamenii de știință de la Universitatea din Texas, Austin, au făcut un alt pas în această direcție. Într-un studiu publicat în revista Nature Neuroscience, cercetătorii au descris o inteligență artificială care ar putea traduce gândurile private ale subiecților umani prin analizarea scanărilor fMRI, care măsoară fluxul de sânge către diferite regiuni ale creierului.

Deja, cercetătorii au dezvoltat metode de decodare a limbajului pentru a prelua tentativa de vorbire a persoanelor care și-au pierdut capacitatea de a vorbi și pentru a le permite persoanelor paralizate să scrie în timp ce se gândesc doar la scris. Dar noul decodor de limbă este unul dintre primii care nu se bazează pe implanturi. În cadrul studiului, a reușit să transforme discursul imaginar al unei persoane în vorbire reală și, atunci când subiecților li s-au prezentat filme mute, a putut genera descrieri relativ precise a ceea ce se întâmplă pe ecran.

„Acesta nu este doar un stimul lingvistic”, a spus Alexander Huth, un neuroștiință la universitate care a ajutat la conducerea cercetării. „Ajungem la sens, ceva despre ideea a ceea ce se întâmplă. Și faptul că acest lucru este posibil este foarte incitant.”

Studiul sa centrat pe trei participanți, care au venit la laboratorul Dr. Huth timp de 16 ore timp de câteva zile pentru a asculta „The Moth” și alte podcasturi narative. În timp ce ascultau, un scaner fMRI a înregistrat nivelurile de oxigenare din sânge în anumite părți ale creierului lor. Cercetătorii au folosit apoi un model de limbaj mare pentru a potrivi tiparele activității creierului cu cuvintele și frazele pe care participanții le-au auzit.

Modelele de limbaj mari, cum ar fi GPT-4 de la OpenAI și Bard de la Google, sunt antrenate pe cantități mari de scris pentru a prezice următorul cuvânt dintr-o propoziție sau o expresie. În acest proces, modelele creează hărți care indică modul în care cuvintele se relaționează între ele. În urmă cu câțiva ani, dr. Huth a observat că anumite bucăți din aceste hărți – așa-numitele înglobări de context, care surprind trăsăturile semantice sau semnificațiile frazelor – ar putea fi folosite pentru a prezice modul în care creierul se luminează ca răspuns la limbaj.

Într-un sens de bază, a spus Shinji Nishimoto, un neuroștiință la Universitatea din Osaka, care nu a fost implicat în cercetare, „activitatea creierului este un fel de semnal criptat, iar modelele de limbaj oferă modalități de a-l descifra”.

În studiul lor, dr. Huth și colegii săi au inversat eficient procesul, folosind o altă IA pentru a traduce imaginile fMRI ale participantului în cuvinte și fraze. Cercetătorii au testat decodorul făcându-i pe participanți să asculte noi înregistrări, apoi au văzut cât de mult se potrivea traducerea cu transcrierea reală.

Aproape fiecare cuvânt era deplasat în scriptul decodificat, dar sensul pasajului a fost păstrat în mod regulat. În esență, decodoarele parafrazau.

Transcrierea originală: „M-am ridicat de pe salteaua pneumatică și mi-am apăsat fața de geamul ferestrei dormitorului, așteptându-mă să văd ochi care se uită la mine, dar în schimb găsim doar întuneric.”

Decodificat din activitatea creierului: „Am continuat să mă apropii de fereastră și să deschid geamul. Am stat pe degetele de la picioare și m-am uitat afară, nu am văzut nimic și am ridicat din nou privirea, nu am văzut nimic.”

În timpul scanării fMRI, participanților li s-a cerut, de asemenea, să-și imagineze în tăcere spunând o poveste; după aceea, au repetat povestea cu voce tare, ca referință. Și aici, modelul de decodare a captat esența versiunii nerostite.

Versiunea participantului: „Căutați un mesaj de la soția mea care spune că s-a răzgândit și că se întoarce.”

Versiune decodificată: „Pentru a o vedea dintr-un motiv oarecare, m-am gândit că va veni la mine și va spune că îi este dor de mine.”

În cele din urmă, subiecții au vizionat un scurt film animat mut, din nou în timp ce erau supuși unei scanări fMRI. Analizând activitatea creierului lor, modelul de limbaj ar putea decoda un rezumat aproximativ al ceea ce vizionau – poate descrierea lor internă a ceea ce vedeau.

Video

Rezultatul sugerează că decodorul AI capta nu doar cuvinte, ci și sens. „Percepția limbajului este un proces condus din exterior, în timp ce imaginația este un proces intern activ”, a spus dr. Nishimoto. „Și autorii au arătat că creierul folosește reprezentări comune în aceste procese.”

Greta Tuckute, neurolog la Institutul de Tehnologie din Massachusetts, care nu a fost implicată în cercetare, a spus că aceasta este „întrebarea de nivel înalt”.

„Putem decoda sensul din creier?” a continuat ea. „Într-un fel ei arată că, da, putem.”

Această metodă de decodare a limbajului a avut limitări, au remarcat dr. Huth și colegii săi. În primul rând, scanerele fMRI sunt voluminoase și scumpe. Mai mult, antrenarea modelului este un proces lung, plictisitor, iar pentru a fi eficient trebuie făcut pe indivizi. Când cercetătorii au încercat să folosească un decodor antrenat pe o persoană pentru a citi activitatea cerebrală a alteia, acesta a eșuat, sugerând că fiecare creier are moduri unice de a reprezenta semnificația.

De asemenea, participanții au putut să-și protejeze monologurile interne, aruncând decodorul gândindu-se la alte lucruri. AI ar putea să ne citească mințile, dar deocamdată va trebui să le citească pe rând și cu permisiunea noastră.